„Az algoritmusok nagyon jól tudnak diszkriminálni. Ezt már külön tudományterület kutatja, megjelent az algorithmic fairness (algoritmikus korrektség) fogalma. Az adattudományban az a legérdekesebb és legveszélyesebb egyszerre, hogy olyan algoritmusokat csinálunk, melyek a társadalomban meglévő egyenlőtlenségeket csökkenthetik, vagy még nagyobbá tehetik, ha nem figyelünk” – ezt Vásárhelyi Orsolya nyilatkozta az nlc-nek, amikor a Women in Data Science (WiDS) konferencia kapcsán beszélgettünk vele.

Ez egy olyan téma, amiről már rengeteg cikk és több könyv is született, de amivel mi, akik „csak éljük a mindennapjainkat”, nem nagyon foglalkozunk, pedig lehet, hogy kellene, ugyanis a mi életünkre is hatással van.

Annak, hogy az algoritmusok mindenhol jelen vannak, sokkal több rétege van annál, hogy milyen véleménybuborékba tudnak bezárni minket a közösségi oldalak vagy éppen milyen hirdetésekkel találkozunk az internetet böngészve. Arról, hogy mekkora tévedés azt hinni, hogy a gépek mentesek minden előítélettől, hogy mennyivel megbízhatóbb és semleges döntéseket tudnak hozni, mint mi, földi halandók, a Vox Youtube-csatornáján jelent meg egy érdekes videó, illetve a Netflix kínálatában már elérhető Shalini Kantayya amerikai filmes és aktivista Coded Bias című dokumentumfilmje.

A Coded Bias Joy Buolamwini, az Algorithmic Justice League (Algoritmikus Igazság Ligája) alapítójának történetével indul. Buolamwini azután hozta létre ezt a szervezet, miután az MIT Media Lab kutatójaként rájött arra, hogy az arcfelismerő rendszerek nem képesek vagy nehezen ismerik fel a sötétebb bőrű embereket. Ez nem új keletű probléma, 2009-ben a Hewlett-Packardnak kellett magyarázkodnia, miután az egész internet felfigyelt egy videóra, ami alapján úgy tűnt, a webkameráik nem működnek tökéletesen.

Buolamwini a film egyik legfontosabb alakja, de nemcsak az ő sztoriját ismerhetjük meg, hanem azt, hogy a mesterséges intelligencia révén lehetővé vált automatizálás hogyan tükrözi vissza vagy erősíti fel a társadalmunkban már meglévő igazságtalanságokat.

Megismerhetünk egy többszörösen kitüntetett tanárt, akinek karrierjét majdnem derékba törte az, hogy egy algoritmikus értékelőrendszer, aminek működéséről az érintettek szinte semmit nem tudtak, alacsony értékelést adott neki, és egy brooklyni társasház lakóiból álló csoportot, akik az ellen küzdöttek, hogy a főbérlő ne éljen vissza a házban felszerelt arcfelismerő kamerákkal.

Egy egykori elítéltet is láthatunk, aki szabadulása után példás életet él, de egy algoritmus úgy döntött, nagy az esélye annak, hogy visszaeső bűnöző lesz, ezért hetente kell jelentkeznie a pártfogó felügyelőjénél, és persze a készítők ellátogattak Kínába is, hogy bemutassák a társadalmi pontrendszert, illetve azt, hogyan a Big Brother Watch nevű szervezet hogyan próbált fellépni, amikor Nagy-Britanniában a rendőrség tesztelni kezdett egy arcfelismerésen alapuló technológiát.

Érdekes következtetése a filmnek, hogy Kínában – ha ugyan nyugati szemmel teljesen abszurd is ez az orwelli világot idéző szisztéma – legalább transzparens az állam azzal kapcsolatban, hogyan figyeli és értékeli polgárait, míg az Egyesült Államokban – többek között Joy Buolamwini – is azért küzd, hogy átláthatóbb és szabályozottabb legyen az, hogyan használják a cégek és az állami szervek a technológia új vívmányait. Ahogyan az egyik szakértő, a technológiával és a társadalmi egyenlőtlenségekkel foglalkozó Virginia Eubanks azon megfigyelése is, hogy ezen vívmányok közül azok, amelyeknek valamilyen negatív aspektusa van, amelyek valamiben korlátoznak minket, azok először a hátrányosabb helyzetben lévő emberekhez jutnak el, amik viszont szinte csak előnyökkel járnak, azok értelemszerűen a gazdagabb rétegekhez.

És ha már az érdekességeknél tartunk, a film készítői talán nem gondolták, hogy utólag milyen jelentősége lett, hogyha csak pár pillanatra is, de feltűnik a filmben Timnit Gebru, aki a Google MI-etikával foglalkozó csapatában volt szakértő, és akinek távoznia kellett, miután egy, a kollégáknak címzett levélben élesen kritizálta a céget amiatt, ahogyan a társadalmi sokszínűséget kezeli.

Joy Buolamwini a 2020-as Women at Sundance Celebration című rendezvényen (Fotó: Suzi Pratt/Getty Images for Refinery29/AFP)

„Gyakran feltételezzük, hogy a gépek semlegesek, pedig nem azok.

Kutatásom nagymértékű nemi és faji előítéleteket fedezett fel az olyan techóriások, mint az IBM, a Microsoft és az Amazon által fejlesztett mesterségesintelligencia-rendszerekben. Ha azt kell kitalálni, milyen nemű ember látható a képen, az összes vállalat lényegesen jobban teljesített a férfi arcok esetében, mint a női arcoknál. Az általam vizsgált vállalatok hibaaránya a világosabb bőrű férfiak esetében nem haladta meg az 1%-ot. A sötétebb bőrű nők esetében a hibák aránya 35%-ra emelkedett. A vezető vállalatok mesterséges intelligencián alapuló rendszerei nem tudták helyesen osztályozni Oprah Winfrey, Michelle Obama és Serena Williams arcát. Amikor a technológia még ezeket az ikonikus nőket is becsmérli, itt az ideje, hogy felülvizsgáljuk, hogyan épülnek ezek a rendszerek, és kit szolgálnak valójában” – írta egy korábbi cikkében Buolawimi.

Hétköznapi szexizmusaink

A fenti sorok nem hatnak újdonságként azoknak, aki figyelemmel követik a mesterséges intelligenciával, a gépi tanulással és úgy általában a technikai fejlődéssel kapcsolatos híreket. Hogy egy viszonylag friss történetet említsünk: az internet 2021 tavaszán felkapta Vargha Dóra, az Exeteri Egyetem adjunktusának posztját arról, hogy a Google fordítója elég sztereotip módon rendel hozzá hímnemet és a nőnemet bizonyos foglalkozásokhoz, jelzőkhöz és tevékenységekhez.

A bejegyzés akkora port kavart, hogy még a még a Google is reagált rá. „A Google Fordító úgy működik, hogy az interneten található sok millió fordítási példából tanul mintákat. Sajnos ez azt jelenti, hogy a modell akaratlanul is megismételheti a már meglévő nemi előítéleteket.” És persze megígérték, hogy dolgoznak azon, hogy a lehető legtöbb nyelven megfelelő módon működjön a fordítás. Ígéretüknek egyébként eleget is tettek, most már mind a hímnemű, mind a nőnemű változatot felkínálja a felület. „Bár még mindig folyamatban van a szélesebb körű bevezetés, reméljük, hogy majd további funkcióknál is tudjuk ezt alkalmazni, és elkezdhetjük kezelni a nem bináris nemet a fordításokban” – tették hozzá.

Az internet akkor is felkapta a fejét, amikor az Apple Card bevezetése után úgy tűnt, hogy alacsonyabb hitelkeretet ad nőknek, mint férfiaknak, még akkor is, amikor ezt anyagi helyeztük miatt nem lenne indokolt. Az eltérésre ráadásul az Apple egyik alapítója, Steve Wozniak is felhívta a figyelmet, ugyanis ő és felesége is ugyanezt tapasztalta. Az ügyben New York állam pénzügyi szolgáltatásokkal foglalkozó kormányszerve, a Pénzügyi Szolgáltatások Minisztériuma vizsgálatot indított, és kiderült, hogy szexizmusról nincs szó, a Goldman Sachs algoritmusa állítólag a mérlegelés során nem veszi figyelembe a kártyatulajdonos nemét.

Jennifer Bailey, az Apple Pay alelnöke bemutatja az Apple Cardot (Fotó: Michael Short/Getty Images)

Ha itt nem is állta meg a helyét a digitális szexizmus vádja, azért a sort lehet folytatni. 2016-ban például abból lett hír, hogy a LinkedIn szakmai hálózatépítő oldal keresési lekérdezésekre válaszul női nevek férfi változatait ajánlotta, például ha valaki az Andrea névre keresett rá, akkor az oldal megkérdezte, hogy nem Andrewra gondolt-e. A vállalat szerint a felhasználók interakciók alapján dobta a rendszer ezeket az ajánlásokat.

Hogy az Amazonnál milyen a munkavállalók helyzete, arról is rengeteget olvasni, és persze arról is, hogy mennyire elöl járnak az mesterséges intelligencia kutatásában. Kínos keresztezése volt a két világnak az, amikor kiderült, hogy 2014-ben kezdtek el dolgozni egy olyan algoritmuson, ami felgyorsította volna az állásra jelentkezők szűrését, és amiről idővel kiderült, hogy elfogult a nőkkel szemben, és nem a jó értelemben. A program kizárta ugyanis azokat a jelentkezőket, akiknek az önéletrajzában az szerepelt, hogy valamilyen női sportcsapat tagjai voltak, vagy olyan iskolába jártak, amit nők számára hoztak létre. Amikor erre fény derült, az Amazon azzal védekezett, hogy csak próbaüzem volt, élesben soha nem használták ezt az algoritmust. Azt, hogy kissé diszkriminatív volt, pedig valószínűleg az okozhatta, hogy a vállalat által egy évtizede gyűjtött önéletrajzokat alapul véve dolgozott az algoritmuson, csak hát azok önéletrajzok többségében férfiaktól érkeztek.

Persze már jóval az Amazon megalapítása előtt is volt hasonló eset, az algoritmikus elfogultság egyik korai példája az 1980-es évek első feléből származik: évente akár 60 nőt és illetve valamilyen kisebbséghez tartozó jelentkezőt utasított el egy londoni orvosi egyetem számítógépes értékelőrendszere, mert korábbi adatokból dolgozott, egy olyan időszakból, amikor nőket és külföldi származású hallgatókat nem nagyon volt szokás felvenni.

Persze más intézményekben is tapasztalható volt hasonló diszkrimináció, a St. George esetét azt tette akkor különlegessé, hogy az emberi döntéseket meghatározó torzításokat sikerült átörökíteni egy automatizált folyamatra.

Tényleg nehéz lenne az összes példát felsorolni arra, hogy a nemi és faji előítéletek hogyan jelennek meg ott, ahol elvileg az emberekre jellemző elfogultságra nem számítanak. Mint kiderült, 2019-ben a Spotify több férfi előadót ajánlott a hallgatóknak, igaz, a nők eleve alulreprezentáltak a zeneiparban, a bejegyzett zeneszerzők és dalszerzők legfeljebb 20%-át képviselik, míg a nagy zenekarok által előadott művek 98%-a férfi zeneszerzőktől származik. De volt idő – a Google azóta állítólag ezt is korrigálta –, hogy a legnépszerűbb keresőmotor semleges kereséseknél népszerű, de szexualizált tartalmakat jelenít meg a nők esetében, például a „top 25 legszexisebb női sportoló” cikkek első oldali találatként jelentek meg, ha valaki a „női sportolókra” keresett.

A jó, a rossz és a csúcstechnológia

Mindemellett persze el kell ismerni, hogy a mesterséges intelligencia számos jó dolgot adhat nekünk, megkönnyítheti az életünket, az elmúlt hónapok hírei közül szemezve például így lehet majd digitális vakvezető kutyája a vakoknak és gyengénlátóknak, hatékony eszköze lehet a mellrák korai felismerésének, segít a járványok modellezésében, illetve a depresszió gyógyítását is megkönnyítheti, hogy csak egy pár példát említsünk.

Ebbe még Siri is belepirulna

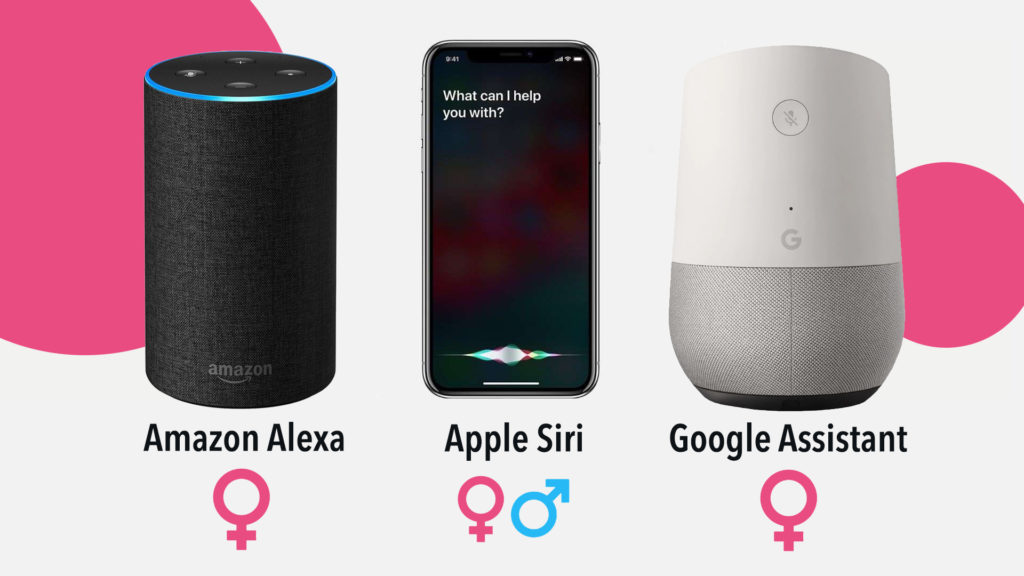

A digitális térben lévő nemi különbségeknek vannak még érdekes vetületei: 2019-ben jelent meg az UNESCO jelentése arról, mennyire problémás az, hogy a virtuális asszisztensek, mint például az Apple Sirije, az Amazon Alexája, a Microsoft Cortanája –, ráerősítenek olyan nemi sztereotípiákra, miszerint a nők egyik fő feladata, hogy kiszolgáljanak másokat, hogy gondoskodva teljesítsék mások kívánságát, és ne nagyon szóljanak vissza.

Meg kell jegyezni, hogy a techcégeknek ugyan van vaj a füle mögött, de nem valamilyen hátsó szándék által vezérelve döntöttek amellett, hogy asszisztenseik női hangon szólaljanak meg, arról van szó, hogy a kutatások szerint az emberek, ha segítségre van szükségük, szívesebben hallanak női hangot. És azért tervezték őket úgy, hogy mindig vidámak és udvariasak legyenek – még ha be is szólnak nekik, szidalmazzák őket –, mert így az emberek szívesebben használják őket, hiszen valószínűleg a többség nem venné jó néven, ha a kütyüje, aminek elvileg meg kellene könnyítenie az életét, felesel vagy kioktatja. Az UNESCO tanulmánya is egyébként pont egy olyan szituációról kapta a címét, ami a való életben nagyon kellemetlen pillanatokat szülne.

„Ha képes lennék rá, elpirulnék” – ezt válaszolta korábban Siri, amikor valaki mondjuk lekurvázta.

A Sirit működtető mesterségesintelligencia-szoftvert azóta persze frissítették, hogy a sértésekre kicsit határozottabban válaszoljon, de állítólag még van hova fejlődni.

A nemek aránya a legnagyobb AI termékeknél (Fotó: nlc illusztráció)

Az UNESCO szerint a fenti jelenség is egy példa arra, hogy a nemi előítéletekkel kapcsolatos problémák a mesterséges intelligencia világában is jelen vannak, ők egyrészt azt javasolják, hogy ne legyen alapértelmezett az, hogy a digitális kütyük női hangon szólalnak meg, és a cégek programozzák úgy az asszisztenseket, hogy a nemi alapú sértéseket vagy célozgatásokat határozottan elutasítsák, például mondják azt, hogy „ez nem helyénvaló”. Fontos lenne az is, hogy a fejlesztői csapatokban a nemek aránya sokkal kiegyenlítettebb legyen.

Mit lehet tenni?

Sokan vannak még, akik úgy gondolják, annak, hogy a nemek közötti, sajnos hosszú múlttal rendelkező előítéletek kikopjanak az életünkből, az kell, hogy az informatika és a természettudományok világa nyitottabbá váljon a nők számára. Nem meglepő módon egyelőre hatalmas a nemek közötti különbség: egyes források szerint a mesterséges intelligencia és az adattudomány területén dolgozó szakembereknek mindössze 22 százaléka nő, ráadásul nagyobb valószínűséggel töltenek be alacsonyabb pozíciókat.

Ha csak több nőt rakunk egy csapatba, ha a nőket nem integráljuk, és nem adunk nekik valódi felelősséget, nem sokat ér a diverzitásba fektetett energia. Egyébként kutatásokból tudjuk, hogy azok a csapatok, amelyek nemcsak genderszempontból sokszínűek, kisebb eséllyel hoznak létre olyan termékeket, melyek másokat diszkriminálnak

– idézzük ismét Vásárhelyi Orsolya adattudóst.

Ha le akarunk számolni az algoritmikus elfogultság minden formájával, akkor persze nemcsak a nőknek kell több lehetőséget biztosítani, hanem minden kisebbség számára, vagyis – csúnyán fogalmazva – reprezentatív legyen a minta, vagyis jól leképezze a társadalmi viszonyokat. Az emberek persze soha nem mentesek az előítéletektől, tudatosan vagy tudattalanul a részlehajlás, az elfogultság, ez a fajta torzítás mindannyiunkban jelen van.

A Wirednél jelent meg egy érdekes cikk azzal kapcsolatban, hogy mi lehet az oka annak, hogy a techcégek még mindig küzdenek az algoritmikus elfogultság okozta problémákkal. A szerző, Yaël Eisenstat Joe Biden nemzetbiztonsági tanácsadója volt még alelnöksége idején, illetve a Facebooknak is dolgozott 2018-ban.

Mint írja, nem hiszi, hogy azok közül, akikkel együtt dolgozott, bárki is szándékosan épített volna bele előítéleteket a rendszerekbe, sokan tényleg egy jobb világot szeretnének építeni, igaz, olyannal sem találkozott, aki tudta volna, hogyan lehet ezt módszeresen kiiktatni. Az ötletek alapján úgy tűnt, sokan nem tudják, hogyan lehet felismerni vagy mérni ilyen torzításokat, ezért több ilyen jellegű tréningre lenne szükség ezeknél a cégeknél. Már csak azért is, mert lehet, hogy valaki felismeri és érti, hogyan nyilvánul meg és hogyan működik az elfogultság egy csoporttal szemben, de nem jelenti azt, hogy egy másik társadalmi csoportnál is hasonlóan szemfüles lesz.

Az, hogy az előítéletek a digitális világban is megjelennek, nagy részben annak köszönhető, hogy olyan bemeneti adatokat használnak a gép tanulásához, amibe ezek már kódolva vannak, lásd például az Amazon önéletrajz-szűrő algoritmusát, és korrekció nélkül az adott algoritmus minden jövőbeli használatában megismétlődhetnek. De van olyan cikk, ahol példaként hozzák fel azt, hogy milyen torzításokat okozhat az az egészségügyi adatokban, hogy a szív- és érrendszeri megbetegedéseket sokáig a férfiak problémájának tekintették. És persze az internet is egy veszélyes hely ebből a szempontból, gondoljunk csak bele abba, mi történt a Microsoft Tay nevű chatrobotjával, aki (vagy ami) egyetlen nap leforgása alatt teljesen egy szexmániás, trágár nácivá vált, miután szegény abból próbált tanulni, hogy megfigyelte, hogyan kommunikálnak az emberek, vagy ahogyan a Google fordító tanult.

Mint a legtöbb fontos kérdésben, itt is nyilván széles korú összefogásra és együttműködésre van szükség, a döntéshozóknak, a vállalatoknak, a fejlesztőknek és nekünk, a felhasználóknak is tenni kell az ügy érdekében, csak a technológiára nem lehet bízni ezt a kérdést, fontos az átláthatóság, a számonkérhetőség, az, hogy a visszajelzések jól működjenek. Az Európai Unióban érvényes általános adatvédelmi rendelet, ahogyan sokan ismerik (GDPR) például több helyen is szót ejt az automatizált adatkezelésről. Íme egy idézet. „Az érintett jogosult arra, hogy ne terjedjen ki rá olyan, kizárólag automatizált adatkezelésen alapuló – akár intézkedést is magában foglaló – döntés hatálya, amely a rá vonatkozó egyes személyes jellemzők kiértékelésén alapul, és amely rá nézve joghatással jár vagy őt hasonlóan jelentős mértékben érinti, mint például egy online hitelkérelem automatikus elutasítása vagy emberi beavatkozás nélkül folytatott online munkaerő-toborzás.”

Egy évvel ezelőtt az Európai Bizottság férfiak és nők közötti esélyegyenlőséggel foglalkozó tanácsadó bizottságának pedig közzétett egy dokumentumot, ami a mesterséges intelligencia nemekre gyakorolt hatásával foglalkozik, illetve az EB most hozta nyilvánosságra az MI szabályozására vonatkozó tervét, amelynek elsődleges célja, hogy korlátozza a magas kockázatú AI alkalmazások használatát, és ami egyelőre csak egy javaslat.

De mi számít szerintük magas kockázatnak?

- Például az olyan AI rendszerek, amelyek veszélyeztetik az emberek biztonságát, megélhetését, ezeket a testület betiltaná, a tiltást kikerülő vállalatokat magas pénzbírsággal sújtaná,

- illetve azok technológiák, amelyek veszélyeztetik az uniós jogok által védett olyan alapvető értékeket, mint a szabadságjogok és a magánélethez való jog. Ilyen például a bűnüldözés és igazságszolgáltatás területén, a migrációs kérelmek elbírálásakor, sebészeti beavatkozásoknál, vagy a munkaerőtoborzásnál használt bizonyos alkalmazások, és a nyilvános helyeken alkalmazott biometrikus azonosító rendszerek. Az ebbe a kategóriába eső szoftverek szigorú követelmények hatálya alá tartoznának, írja az MTI.

Szexizmus régen és most:

- Szexizmus, kicsinálás – mit tettünk a női sztárokkal a ‘90-es években?

- „Elég okosnak tűnsz ahhoz képest, hogy nő vagy”

- A nőket hajlamos egyszerűen elfelejteni a tudomány